Case omschrijving

Net als in mijn vorige blog post heb ik een Proof of Concept gemaakt om grote hoeveelheden XML bestanden te transformeren, het gaat dan 3000 bestanden per keer met een totale grote van 18 gigabyte. Voor dit artikel kan ik wegens privacy redenen niet de echte data gebruiken en heb ik een dataset gebruikt van https://www.kaggle.com/datasets. Het gaat hier om een dataset van landen en de wijnen.

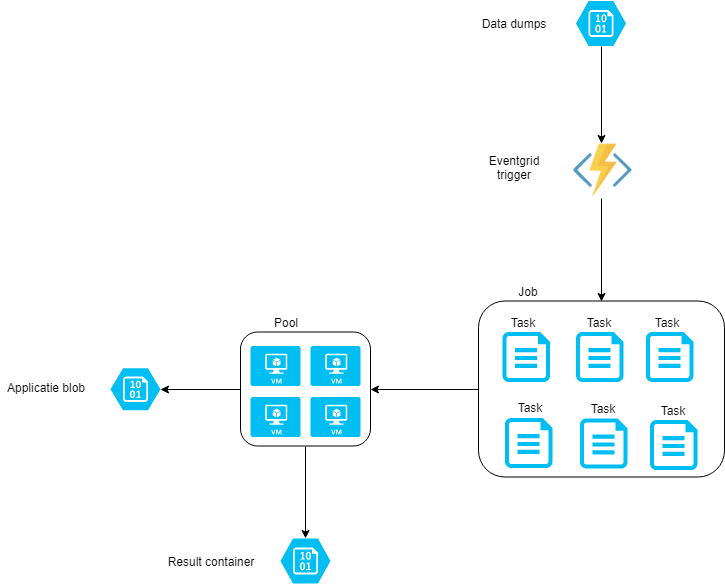

Het doel is om de wijnen uit de XML dump te halen en deze om te zetten naar een JSON formaat en deze bestanden te uploaden in een blob container. We krijgen dus per wijn een JSON bestand in een blob container. Dit alles moet gebeuren op basis Azure Batch met een Azure Function als orchestrator.

Wat is de opzet van de POC

We gaan de XML bestanden transformeren doormiddel van een Azure Batch component en we starten en beheren de Azure Batch doormiddel van een Azure Function.

De Azure Function zal de XML bestanden toevoegen aan een Job in Azure Batch doormiddel van een event grid trigger en via een httptrigger is de voortgang te zien van het batch proces.

Wat is Azure Batch

Azure Batch is plat gezegd eigenlijk een beheer tool voor virtuele machines. Elk van deze machines kan een taak oppakken en dit als input gebruiken voor een commandline applicatie en het resultaat uploaden in bijvoorbeeld een blob container.

Voor de complete omschrijving wat je met Azure Batch kunt doen verwijs ik je graag door naar de Microsoft site https://azure.microsoft.com/nl-nl/services/batch/

Hoe werkt het Proof of Concept

Azure Batch bestaat uit een aantal componenten.

- Een Task is een opdracht welke uitgevoerd dient te worden op een node.

- Een Job is een verzameling van tasks. Aan een Job hangt ook een Pool.

- Een Pool is een verzameling van nodes.

- Een Node is een virtuele machine welke een van de tasks gaat uitvoeren.

Ik heb 40 bestanden met landen en wijnen. 1 bestand is ongeveer 75 mb groot. Voor testdoeleinden zijn dit dezelfde bestanden met een andere naam. Dit is meer om een gelijkwaardige load op de functie te krijgen als bij de echte POC.

Ik heb een Azure Function welke een event grid trigger heeft welke afgaat op het moment dat er een bestand wordt geupload in de blobcontainer.1

2

3

4

5

6

7

8

9

10

11

12[]

public static async Task Run(

[EventGridTrigger] EventGridEvent eventGridEvent,

ExecutionContext context,

ILogger log)

{

var data = JsonConvert.DeserializeObject<StorageBlobCreatedEventData>(eventGridEvent.Data.ToString());

string name = data.Url.Split('/').Last();

log.LogInformation($"C# Blob trigger function Processed blob\n Name:{name}");

await RunBatch(log, context, name);

}

De bestandsnaam wordt uit de URL gehaald en doorgestuurd naar de methode RunBatch.

De methode RunBatch initialiseert een BatchClient met de credentials welke opgegeven zij in de config.1

2

3

4

5

6

7

8

9private static async Task RunBatch(ILogger log, ExecutionContext context, string name)

{

var config = ReadSettings(context);

BatchSharedKeyCredentials credentials = new BatchSharedKeyCredentials(config["BatchUrl"], config["BatchAccount"], config["BatchKey"]);

using (BatchClient batchClient = BatchClient.Open(credentials))

{

}

}

Hierna gaan we kijken of er al een job bestaat in het Azure Batch Account. Als er al een job bestaat en hij is nog actief of wordt aangemaakt voegen we hier een task aan toe. Als er geen job actief is of wordt opgestart dan maken we een Job aan. Dit gebeurt in de CreateJob methode.1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45private static async Task RunBatch(ILogger log, ExecutionContext context, string name)

{

var config = ReadSettings(context);

BatchSharedKeyCredentials credentials = new BatchSharedKeyCredentials(config["BatchUrl"], config["BatchAccount"], config["BatchKey"]);

using (BatchClient batchClient = BatchClient.Open(credentials))

{

string jobId = string.Empty;

try

{

batchClient.CustomBehaviors.Add(RetryPolicyProvider.ExponentialRetryProvider(TimeSpan.FromSeconds(5), 3));

if (batchClient.JobOperations.ListJobs().Any())

{

var jobs = batchClient.JobOperations.ListJobs();

CloudJob activeJob = jobs.FirstOrDefault(job => job.State == JobState.Active || job.State == JobState.Enabling);

if (activeJob != null)

{

log.LogDebug("Job still active");

CreateTaskIfNotExists(batchClient, activeJob.Id, name);

}

else

{

jobId = await CreateJob(name, batchClient);

}

}

else

{

jobId = await CreateJob(name, batchClient);

}

}

catch (Exception e)

{

log.LogError(e, e.Message);

if (!string.IsNullOrEmpty(jobId))

{

log.LogDebug($"Deleting job: {jobId}");

await batchClient.JobOperations.DeleteJobAsync(jobId);

}

}

}

}

Een Job heeft een pool met nodes nodig welke het werk uitvoeren. We gaan deze dus eerst aanmaken.

- We specificeren het besturingssysteem in dit geval staat de waarde 5 voor Windows Server 2016 voor de overige waardes check de Azure Guest OS Releases https://docs.microsoft.com/en-us/azure/cloud-services/cloud-services-guestos-update-matrix#releases

- We specificeren een virtuele machine size in dit geval een standard_d1_v2 voor de overige ondersteunde machines check https://docs.microsoft.com/en-us/azure/batch/batch-pool-vm-sizes#supported-vm-families-and-sizes

- We specificeren hoeveel tasks er per node gedraaid mogen worden in dit geval 4. Er zullen dus 4 tasks per keer op de node worden gestart.

- We specificeren welke applicatie er op de node gedraaid dient te worden. Dit moet een applicatie of script zijn welke via de commandline te draaien is. Deze applicatie kan als een zip bestand worden gupload in de portal.

- We zetten de lifetime op PoolLifetimeOption.Job dit wil zeggen zodra alle tasks in de Job klaar zijn zal de pool verwijdert worden en zul je dus ook niet meer betalen voor de virtuele machines.

1 | private static PoolInformation CreatePool() |

Nu we een Pool hebben kunnen we deze koppelen aan de Job. De CreateJob methode maakt een unieke naam aan voor de job doormiddel van een timestamp te prefixen met “WineConverter”.

1 | private static async Task<string> CreateJob(string name, BatchClient batchClient) |

We controlleren eerst of de task al is aangemaakt en is toegevoegd aan de job, zoniet dan voegen we hem toe. De naam van de task mag alleen letters en cijfers bevatten en een koppelteken en underscore.

Ook stellen we in welke package de task moet starten met welke argumenten. Hier starten we converter.exe met als argument een naam van de blob (in dit geval een XML bestand met wijn data).

De converter.exe bevat alle logica om de xml te verwerken en het resultaat te uploaden in een Azure blob container.

In de Azure portal kan je een package uploaden welke op de nodes geinstalleerd moeten worden. Meer informatie over hoe packages werken met Azure batch is te vinden op: https://docs.microsoft.com/en-us/azure/batch/batch-application-packages

1 | private static void CreateTaskIfNotExists(BatchClient batchClient, string jobId, string blobName) |

De volledige code

Zie hieronder de volledige code. Er is een extra function aan toegevoegd met een httptrigger zodra je deze aanroept worden alle jobs met de bijhorende tasks weergegeven en de status van de tasks. Het endpoint is nu niet beveiligd maar dit is omdat het een demo is.

1 | using System; |

Conclusie

Azure batch is echt een serieuze keuze als je grote hoeveelheden data moet verwerken en je wilt in controle zijn wat er allemaal gebeurt.

Je kan zowel horizontaal als verticaal schalen en het aantal nodes wat het werk kan doen is standaard 20 maar je kunt een request doen voor meer nodes. Voor de recource limieten check de documentatie https://docs.microsoft.com/en-us/azure/batch/batch-quota-limit.

Ik ken zelf weinig projecten waar ze Azure batch gebruiken maar ik ben echt onder de indruk hoe simpel en krachtig Azure batch is plus je betaald alleen voor de tijd dat de nodes ook echt iets doen dus geen vaste maandelijkse kosten.

Deze POC heeft het qua performance zijn doel wel behaald wat we voor ogen hadden alleen het bevat toch net te veel stappen om het volledig via CI/CD gemakkelijk te deployen.

In een volgende blog zal ik de uiteindelijke oplossing uitwerken met verschillende functie apps op een consumption plan welke aan alle eisen voldoet.